本文介绍使用 Ollama 本地化部署 Deekseek 1.5b 的详细步骤,部署环境包括 Windows11 和 CentOS7,其中 CentOS7 没有 GPU 资源。

Ollama 是一个开源的本地大模型运行框架。除此以外还有 Hugging Face Transformers + Python 等部署方式。

一、Windows

1、下载安装 Ollama

ollama 官网(ollama.com)找到 Download,安装包下载好后直接安装(网络不好请使用代理)。

2、运行 Ollama

双击 Ollama 图标或者命令行输入 ollama serve 启动。

新开一个 powershell 窗口,输入 ollama -v,打印版本信息即为安装成功。

3、修改安装位置(可选)

(1)Ollama 程序位置

程序位置默认在 C:\Users\你的用户名\AppData\Local\Programs\Ollama,可以通过用户环境变量 Path 查看到。剪切 Ollama 文件夹粘贴到其他盘,比如我是放到 D 盘。

修改环境变量 Path = D:\Ollama (刚才粘贴的位置)

(2)模型位置

模型默认位置在 C:\Users\你的用户名\.ollama,把 .ollama 剪切到其他盘。我是把 .ollama 复制到了 D:\Ollama 位置统一管理。

增加环境变量 OLLAMA_MODELS = D:\Ollama\.ollama\models(.ollama 位置 + models)

实测修改模型位置后重启电脑才生效。重启 ollama,C 盘会重新创建 .../用户名/.ollama,大小只有四百多B,不用管它。模型文件也不会放在这里。

4、下载模型

命令和 docker 风格一样,run 会先下载模型,然后再跑起来。

常用命令:

# 1、pull model and run

ollama run deepseek-r1:1.5b

# 2、list models

ollama list

# 3、remove model

ollama rm deepseek-r1:1.5bollama run 之后,成功进入和 deepseek 交互的界面。

退出交互界面:/bye 或者 ctrl + d

5、卸载 Ollama

浅尝辄止后,为了节省磁盘,可以进行卸载,具体步骤如下:

(1)ollama rm 删除 model

(2)用 Ollama 程序位置目录下的 unins000.exe

PS:Windows 应用卸载会找不到,如果修改过Ollama 程序位置。

(3)清理环境变量(可选)

二、Linux(CentOS7)

1、Ollama 快速安装

# 官方

curl -fsSL https://ollama.com/install.sh | sh

# 国内镜像

curl -fsSL https://aliendao.cn/ollama/install.sh | sh2、手动安装

在 Github 搜索 Ollama 找到对应的安装程序下载,比如 ollama-linux-amd64.tgz

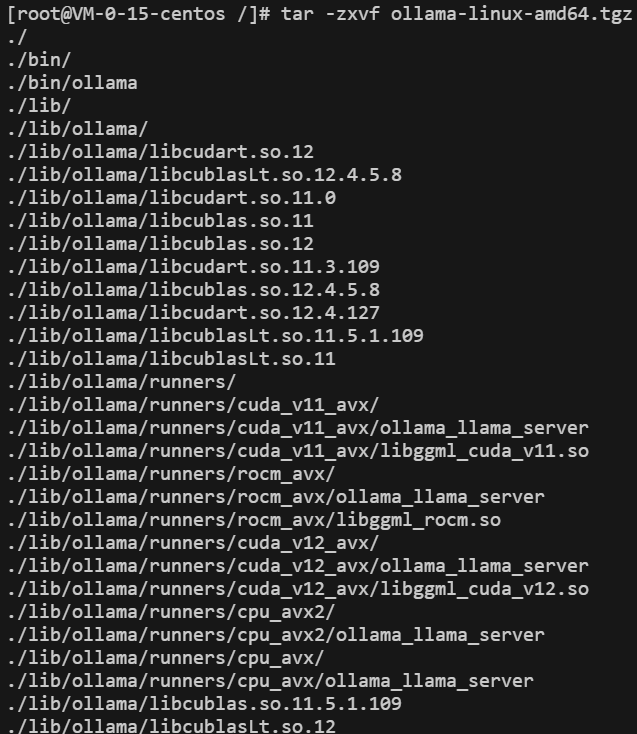

下载好之后,上传到 Linux 上。解压:tar -C /usr -zxvf ollama-linux-amd64.tgz

注意:不要放到根目录下解压!!!下图解压是错误的,直接解压,目录 /bin 和 /lib 会被清空覆盖。一定要指定存放地址 -C /usr !!!

解压主要是两个目录 /usr/bin/ollama 和 /usr/lib/ollama,卸载的时候把这两个目录删除掉即可。

3、运行 Ollama

# 非守护进程启动

ollama serve

# 守护进程启动(后面注册成 systemd 单元启动, 不用这里 nohup 启动)

nohup ollama serve &验证是否正在运行:ollama -v

4、配置

注册 ollama 到 systemd 服务单元:vim /etc/systemd/system/ollama.service

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/bin/ollama serve

User=root

Group=root

Restart=always

RestartSec=3

Environment="OLLAMA_HOST=0.0.0.0"

Environment="OLLAMA_MODELS=/data/ollama/model"

[Install]

WantedBy=default.target重载配置:systemctl daemon-reload

启动服务:systemctl start ollama

设置开机启动:systemctl enable ollama

三、下载 Deepseek

因为这边 linux 环境是没有显卡的,只能选择 Deepseek-r1:1.5b。通过 ollama 下载,ollama 的指令类似于 docker,ollama run 会自动下载模型。下载界面看到 1.5b 大概有 1.1 GB。

运行模型,进入问答交互界面:ollama run deepseek-r1:1.5b

退出交互界面:ctrl + d、/bye

下载一会会降速,ctrl + c 退出,重新 ollama run 下载速度恢复正常。重复这个过程直至下载完成。